Indexarea WordPress site-uri web

Configurarea corectă a site-ului indexeze un impact direct asupra succesului promovării sale viitoare în motoarele de căutare. In acest articol voi explica cum se configurează în mod corespunzător site-uri de indexare pe WordPress și a scăpa de conținut duplicat. Mai jos operațiune de tehnologie este testat în mod repetat și sa dovedit a fi excelent.

Esența acestei tehnologii este de a fi utilizate pentru a configura indexarea fișier robots.txt combinat cu roboți meta-tag. Astfel, vom crea o protecție împotriva două niveluri de conținut duplicat. Cu toate acestea, chiar și o protecție dublă nu garantează rezultate 100%, deoarece motoarele de căutare pot ignora setarea de indexare. Din fericire, acest lucru se întâmplă foarte rar, dar, de asemenea, ne uităm la moduri de a proteja și de la ea.

Înainte de a trece direct la luarea în considerare a caracteristici de ajustare de indexare pentru a determina care pagini există în WordPress, care ar trebui să li se permită să indice și care sunt interzise. Sunt de părere că permisul ar trebui să fie indexate, numai acele pagini care avem nevoie. Orice altceva trebuie să fie închise.

Principalele tipuri de pagini în WordPress

În WordPress, există mai multe tipuri de bază de pagini care pot fi necesare în activitatea noastră:

De asemenea, există 404 de pagini de eroare, pagini de căutare și atașamente, etc. dar cu ei nu funcționează, pentru că în 99% din cazuri, acest lucru nu este necesar.

Cele mai multe proiecte convenționale utilizează doar primele patru tipuri de pagini care sunt disponibile în implicit Wordrpess. Pentru a avea acces la toate celelalte caracteristici ale motorului necesitatea de a face modificări adecvate codul șablonului. Oricum, ne vom uita la versiunea completă a codului, pentru a evita orice probleme în viitor. Codul este universal și va funcționa chiar dacă unele funcționalități nu este implementată.

Folosind roboți meta tag-uri

Valoarea vom folosi patru modele de bază:

Există alte modele care pot fi utilizate ca o valoare pentru atributul în conținutul roboți meta tag. Ele nu vor fi considerate ca fiind aplicarea practică a acestora mici.

Meta-tag cod de control roboți pentru site-ul WordPress

Ca un exemplu, am citat o versiune simplă a codului, care vă permite să automatizeze producția de roboți meta tag-ul în site-ul rulează de administrare WordPress. În acest exemplu, să nu fie în măsură să schimbe în mod arbitrar valoarea meta tag-uri pentru pagini individuale, prin intermediul unui panou administrativ al site-ului. Am eliminat această posibilitate, ca și în 99% din cazuri nu este pur și simplu nu este nevoie. În plus, este posibil să se faciliteze considerabil cod.

Pentru a seta codul de pe site-ul dvs., pur și simplu adăugați la fișierul header.php între tag-uri

. Acum, să se ocupe cu cod.După cum se poate observa din exemplul, facem o verificare de rutină a tipurilor de pagini și în funcție de acest lucru vom obține o etichetă de roboți meta cu valoarea dorită. Pentru a determina tipurile de pagini, vom folosi funcțiile de WordPress încorporate, așa-numitele tag-uri condiționale.

Dacă aveți nevoie să dezactivați doar câteva pagini de înregistrări specifice, va trebui să faceți upgrade puțin codul. Alternativ, se poate utiliza pas arbitrar. Cu exemple detaliate despre cum să facă acest lucru pot fi găsite în articolul de câmpuri arbitrare WordPress.

Deci, de la meta-tag-uri, ne-am înțeles. Ne întoarcem acum la cea de a doua parte a articolului si uita-te la exemple de cele mai bune, în opinia mea, un fișier robots.txt

fișier robots.txt pentru site-ul WordPress

Fișierul robots.txt este utilizat pentru a configura indexarea site-ului dvs., în general. De obicei, numai design-ul general folosit în ea, care poate interzice indexarea anumitor secțiuni ale site-ului. Cu toate acestea, unii reușesc să transfere o leagă paginile individuale, în scopul de a le exclude din căutare. Nu cred că este o idee bună, așa că, în exemplul de mai jos sunt doar generale de proiectare.

Protecția împotriva conținutului duplicat pe pagină în secțiunea

Din păcate, chiar și toate metodele de mai sus nu se poate da o garanție de 100%, care a închis indexarea paginii nu va fi indexat. În mod alternativ, se poate face referire la pagina închisă, și poate apărea în continuare în indexul motoarelor de căutare. Acest lucru se întâmplă uneori. Nu este nimic în neregulă cu faptul că, în cazul în care pagina nu este o copie exactă a unei alte pagini, care, în plus, vă puteți promova.

O protecție suplimentară împotriva conținutului duplicat este deosebit de relevant în promovarea pagini cu navigarea în pagină. Acestea sunt secțiuni ale paginii, tag-uri, etc. Pentru a evita o duplicate complet, există un mod foarte simplu - pentru a opri ieșirea descrierii principală pagină cu paginația activă.

Astfel, descrierea va fi afișată numai pe prima pagină. În trecerea la a doua, a treia, etc. Descrierea nu va fi afișată. Acest lucru va evita suprapunerea textului principal în pagini cu pagina de navigare.

Dacă utilizați toate cele trei metode, puteți obține o calitate de 100% a site-ului. În conformitate cu calitatea de 100%, în acest caz, mă refer la situația în care în indexul motoarelor de căutare există doar paginile de destinație și gunoi complet absente. Cel mai simplu mod de a verifica dacă totul se face corect - se referă la motorul de căutare Google.

Acest motor de căutare este foarte ușor de a verifica site-ul, astfel încât toate paginile care sunt considerate utile, intră în indicele principal. Orice altceva se încadrează în așa-numitul index suplimentar. Vreau doar să rețineți că, în căutarea implică doar pagina cu indicele principal, astfel încât cea mai mică calitatea site-ului, în opinia Google, mai rău.

Pentru a verifica calitatea, puteți utiliza următoarea structură, care trebuie să fie introduse în caseta de căutare Google.

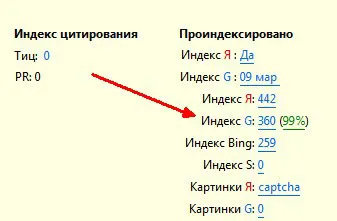

Primul design vă va permite să știi ce numărul total de pagini indexate de motoarele de căutare. Al doilea Designul va arăta cât de multe pagini ale site-ului este în indexul principal Google. Împărțind a doua valoare la prima și înmulțirea cu 100, știm calitatea unui site ca% din Google vedere motor de căutare.

Pentru claritate am cita date cu privire la unul dintre proiectele mele vechi.

De asemenea, pentru a verifica calitatea, puteți utiliza plug-in pentru browser-ul dvs. RDS Bar. Se toate calculele sunt efectuate automat.

Folosind metodele descrise mai sus se va îmbunătăți în mod semnificativ calitatea site-ului în ochii motoarelor de căutare prin eliminarea de conținut duplicat, care, la rândul său, va afecta în mod pozitiv dinamica progresului. Indicele va fi prezent doar pagina de destinație, și nimic mai mult.

În unele cazuri, acest lucru poate duce la o ușoară pierdere de trafic, prin reducerea numărului total de pagini din index. Acest lucru se întâmplă pentru motivul că unele pagini cu versiunea încă se încadrează în indexul motoarelor de căutare și aduce un trafic. Când le închidem de a fi indexate, atunci excludem posibilitatea acestui trafic suplimentar. Aceasta este o mică taxă pentru îmbunătățirea calității întregului site. Oricum, toată lumea alege ce vrea mai mult.

Asta e tot. Mult noroc și succes în promovarea site-urilor!

S-au găsit o eroare? Selectați-l și apăsați pe Ctrl + Enter

versiune de tipărit