Informații proceselor de căutare, prelucrare, depozitare și de transport

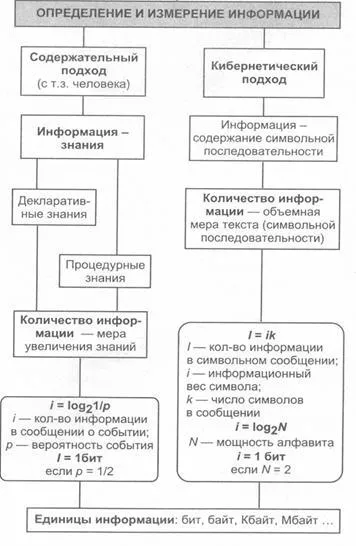

Principalele abordări la definiția conceptului „informații“. Date de măsurare în teoria informației și tehnică. Calcularea cantității de informații.

Termenul „informație“ vine de la informatio latină. ceea ce înseamnă o explicație, prezentare de conștientizare. Din punctul de vedere al filozofiei materialiste a informației este o reflectare a lumii reale prin utilizarea informațiilor (mesaje). Mesajul - este o formă de prezentare a informațiilor sub formă de voce, text, imagine, digitale, date, grafice, tabele, etc. În termeni generali, informațiile - este un termen științific general, care include schimbul de informații între oameni, schimbul de semnale între insufletite și natura neînsuflețită, oameni și dispozitive.

Conceptul de informație este una dintre cele mai fundamentale în știința modernă. Cu toate acestea, definiția formală a acestui concept este dificil (ca conceptul de „punct“ sau „direct“ în geometrie). În înțelegerea de zi cu zi cu „informații“, un termen de obicei, asociativ-șoară unele informații, date, cunoștințe, etc.

Mesaj de la sursă la destinație este întotdeauna transmis prin orice mediu, care, în acest caz, „canal de comunicare“ (sunet - aer, text - foaie și altele).

Natura umană la percepția subiectivă a informațiilor prin intermediul unor on-bor proprietățile sale: importanța, fiabilitatea, promptitudinea, accesibilitate, etc. În acest sens, unul și același mesaj transmis de la sursă la destinație poate transmite informații în diferite grade.

Reprezentanții conceptului atributivă (. Abdeev, Bazhenov, Petrushenka, Ursula și altele) cred că informațiile - atributul de materie, și anume, proprietatea oricărui sistem de realitate obiectivă.

(Tsidrya. Afanasiev, Schrader și altele) Reprezentanții conceptului antropocentrică cred că informația nu poate fi considerat uman și în afara companiei; este privit ca un punct de semnal, sistemul obținut din lumea exterioară.

Informații de măsurare (abordare diferită)

Cele mai des utilizate următoarele două metode de măsurare a informațiilor: volumetric și probabilistă.

Abordarea Volumetric. În notație binară semne 0 și 1 va fi numit un pic (din limba engleză a doua expresie digiți binary - cifre binare). Dă preferință la sistemul binar, deoarece dispozitivul tehnic cel mai simplu de a pune în aplicare două stare fizică opuse: magnetizat / magnetizat nu on / off .. încărcate / nu a fost încărcat și altele.

Volumul de informații stocate caractere binare în memoria calculatorului sau pe un mediu de stocare extern este calculat pur și simplu prin numărul necesar pentru o simboluri binare de scriere. În această imposibilitate, dar noninteger numărul de biți.

Pentru ușurința de utilizare introduse și mai mare decât informația coli-bit unitate de operare. Astfel, un cuvânt binar de opt caractere care conține un octet de informație, 1024 kilobytes formă octet (KB), 1024 kilobiți - megabytes (MB), și 1024 megabytes - gigaocteți (GO).

Entropia (probabilitate) abordare. Această abordare este adoptată în teoria informației și codificare. Această metodă de măsurare se bazează pe următorul model: destinatarul mesajului are o anumită idee a probabilității de apariție a anumitor evenimente. Aceste reprezentări sunt în general nesigure și exprimă probabilitatea cu care se așteaptă acest lucru sau acel eveniment. măsură generală de incertitudine numită entropie. Entropia este caracterizat de o probabilitate de dependență totală matematică a acestor evenimente.

Cantitatea de informații din mesajul este determinat de modul în care a diminuat măsura după ce a primit un mesaj: cu cât entropia sistemului, cu atat mai mare gradul de incertitudine. Mesajul primit este complet sau parțial elimină această ambiguitate, prin urmare, cantitatea de informații pot fi măsurate prin măsura scăderii entropiei sistemului după primirea mesajului. Ca o măsură a cantității de informație este primit aceeași entropia, dar cu semn opus.

Să considerăm exemplul calculării valorii informațiilor raportate apariția unuia dintre N evenimente la fel de probabile. Notăm cantitate numerică care măsoară incertitudinea (entropie) prin H. Valorile N și H sunt legați o relație funcțională: H = f (N). Această caracteristică este în mod evident în creștere, și anumite non-negativ pentru toate valorile de 1, 2, ..., N.

Vom nota cu incertitudinea H1, existentă înainte de a avut loc evenimentul. Prin H2 - incertitudine după eveniment. Apoi, pentru I - cantitatea de informații cu privire la rezultatul experienței - luăm diferența între incertitudine înainte și după experiența: I = H1 - H2.

În cazul în care se obține rezultatul specific, care a îndepărtat incertitudine (ca H2 = 0). Astfel, valoarea informațiilor primite coincide cu entropia originală. Incertitudinea, încastrată în experiment coincide cu informațiile cu privire la rezultatul acestui experiment.

Definiți H = f function (N). Noi variază N (numărul de rezultate posibile) și M (număr de experimente). Numărul total de rezultate este egal cu X = N M. Fiecare rezultat - un vector de lungime M. constând din simboluri 1, 2, ..., N.

Situația cu experimente care efectuează M poate fi privit ca un sistem complex format din subsisteme independente reciproc - experimente simple. Entropia unui astfel de sistem este de M ori mai mare decât entropia unui sistem (așa-numitul „principiul aditivitatea entropiei»): f (N M) = M f (N).

Logaritm din partea stângă și dreaptă a ecuației X = N M. obține:

Substituind valoarea pentru M în ecuația f (N M) = M f (N), obținem:

Notând o constantă pozitivă. obținem formula :.

Formula rezultată se numește formula Hartley.

Important cu introducerea unei cantități este întrebarea de ce să ia pentru unitatea de măsură. Evident, H este egal cu unu, atunci când N = 2. Cu alte cuvinte, ca unitate de informații primite asociate cu efectuarea unui experiment care constă din primirea unuia dintre cele două rânduri în mod egal-iskho (de exemplu, o monedă) Toss. O astfel de cantitate de unitate de informație se numește un pic.

Toate rezultatele N discutate mai sus sunt la fel de probabile și experiență în acest putem presupune că o „cotă“ fiecărui rezultat, există un N-lea a incertitudinii totale de experiență :. Probabilitatea Pi i -lea rezultat; Acesta este egal cu 1 în mod clar / N. Astfel:

Aceeași formulă (final) este luată ca o măsură a entropiei într-un caz în care probabilitatea diferitelor experiențe egal probabile rezultate (adică, valoarea Pi poate varia). Această formulă se numește formula lui Shannon.

Notă: pentru volumul de date Vd raportate aici se referă la numărul de caractere în mesaj (de exemplu, ceea ce se înțelege prin biți printr-o abordare de volum).

Exemplul 1. Determinarea cantității de informații asociate cu apariția fiecărui personaj în mesaj în limba rusă. Presupunem că N = 34 (33 de caractere și spații). apoi:

Exemplul 2. Cu toate acestea, în cuvintele limbii române (și alte limbi) litere diferite apar în mod diferit de multe ori. Dacă vom folosi tabela de probabilitate folosesc metode diferite de frecvență caractere ale alfabetului română, apoi de Shannon poate calcula valoarea lui H. Acest rezultat va fi ușor mai mică decât sa calculat mai sus (4,72), deoarece valoarea calculată cu formula AN Hartley, este cantitatea maximă de informații care ar putea să cadă pe un singur semn.

Notă: Pentru același mesaj la valori diferite ale cantității de informații pot fi obținute folosind diferite abordări (dar aproximativ egale). Cantitatea de informații primite de formulele Shannon-Hartley nu poate fi mai mică decât cantitatea de informație obținută metoda volumetrică.

Exemplul 3. Se consideră alfabetul format din două simboluri 0 și 1. Dacă presupunem că kami cu valorile 0 și 1 în alfabet binar asociat identic probabilitatea lor apariție (P0 = P1 = 0,5), cantitatea de informație per caracter la binar codifică Vania este egală cu N = log2 2 = 1 bit. Astfel, cantitatea de informații (în biți), închis într-un cuvânt binar este egal cu numărul de cifre binare în ea.

Altele (mai puțin cunoscute) metodele de măsurare de informare

Abordarea algoritmice. Orice post poate fi atribuită caracteristica cantitativă reflectând programului de complexitate (mărime), care îi permite să producă. Deoarece există mai multe calculatoare diferite și limbaje de programare, adică moduri diferite de a scrie algoritmului, atunci certitudine este dat unele mașini specifice, cum ar fi o mașină Turing. Apoi, după cum este necesar caracterizarea cantitativă a mesajelor poate lua un număr minim de mașină de stat interne pentru a juca acest mesaj.

Abordarea semantică. Pentru a măsura conținutul de informație semantică, adică, valoarea sa la nivel semantic, cea mai înaltă recunoaștere a măsurii de tezaur. care leagă proprietăți semantică CAL a informațiilor din capacitatea utilizatorului de a primi mesaje primite. Acesta utilizează conceptul de „utilizator tezaur.“

Tezaur - un set de informații disponibile în favoarea Vatel sau a sistemului.

Numărul maxim de informații semantice achizițiile Ic de consum, la coordonarea conținutului semantic S cu tezaur SP său. incomig informații ușor de înțeles pentru utilizator și poartă nu cunoscut anterior (lipsește în tezaur său) informații.

Atunci când se evaluează semantic aspectul (semnificativ) a informațiilor necesare pentru a depune eforturi pentru a armoniza și cantitățile S Sp.

Măsura relativă a cantității de informație semantică poate fi meaningfulness coeficient C, care este definit ca raportul dintre informația semantică volumul său :.

O abordare pragmatică. Această măsură definește utilitatea informațiilor (valoare) pentru a atinge obiectivul de către utilizator. Această măsură este, de asemenea, o valoare relativă, din cauza singularități tyami-utilizare a acestor informații într-unul sau un alt sistem. Valoarea de informații utile pentru măsurarea în aceleași unități (sau aproape), în care măsurabilă funcția ryaetsya-țintă.