roboți Meta sau

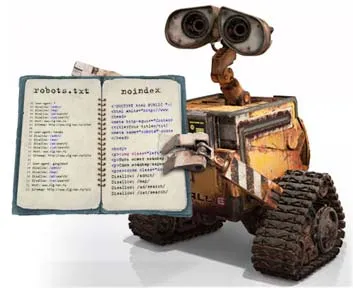

ROBOTI META sau robots.txt?

Interzicerea de indexare cu ajutorul fișierului «robots.txt»

Una dintre opțiuni cum să facă acest lucru - utilizarea «robots.txt» fișier. Mai jos este un exemplu de acest fișier:

Directiva «User-agent»

După cum puteți vedea, fișierul conține o referire la un agent special, motorul de căutare prin directiva «User-agent». Folosindu-l, vă spun, poate permite un singur motor de căutare pentru a indexa un site, în timp ce altele nu sunt. Sau, pentru a permite motoarelor de căutare să indexeze diferitele secțiuni diferite ale site-ului. Puteți merge, de asemenea, direct la toți agenții motoarelor specificate ca valoare pentru Directiva «User-agent» simbolul „*“ căutare. Astfel, un agent de căutare, citirea «robots.txt» fișier și să nu-l găsesc instrucțiuni de la sine, va căuta regulile descrise pentru «User-agent: *».

Mai jos este o listă cu unele «User-agent» pentru diferite motoare de căutare:

- "Yandex" - motor de căutare agent "Yandex".

- «Googlebot» - agent motor de căutare «Google».

- «Googlebot-Mobile» - agent motor de căutare «Google», accesează cu crawlere paginile pentru indexul nostru mobil.

- «Googlebot-Image» - agent motor de căutare «Google», accesează cu crawlere pagini pentru indexul nostru de imagini.

- «MediaPartners-Google» - agent motor de căutare «Google», accesează cu crawlere pagini pentru a determina conținutul de «AdSense».

- «Adsbot-Google» - agent motor de căutare «Google», scanează paginile, evaluarea calității paginilor de destinație pentru «AdWords».

- «StackRambler» - agent căutător «Rambler».

Directiva «Disallow»

Și ce urmează este posibil să se închidă site pentru indexare toate motoarele de căutare:

Destul de des se pune întrebarea dacă este sau nu este necesar pentru a pune un „slash“, după numele secțiunii specificat în „Disallow“ directivă? Faptul că oferă același conținut pentru căutarea www.example.ru/pda/ www.example.ru/pda/ și sisteme www.example.ru/pda sunt complet diferite pagini ale site-ului, astfel încât în cazul în care software-ul și site-ul pentru www.example.ru/pda. în «robots.txt» trebuie să specifice:

Astfel, vom închide ambele secțiuni ale indicelui pentru toate motoarele de căutare.

Un efect secundar al această ultimă metodă poate fi ca Disallow: / gadgeturile interzice indexarea paginilor precum /pda.html. /pda-download.html și așa mai departe. d. t. e. toate paginile care încep cu minciuni și PDA în directorul rădăcină al site-ului.

Codul de mai jos nu interzice nimic, și anume permite să indexăm toate paginile site-ului pentru toate motoarele de căutare ..:

Contactați în sensul «Interdicție» directivă este o directivă «Permiteți». «Permite» indice de permise specificate în secțiunea ei a site-ului. Să presupunem că vrem să împiedice indexarea întregului site, cu excepția secțiunii / Info /. În acest caz, nu avem nevoie pentru a lista toate celelalte secțiuni din orientările «Interdicție», pentru a le închide de a fi indexate. Soluția corectă este următorul cod:

Deci permitem toate motoarele de căutare să indexeze secțiune a site-ului / info /. dar interzis să indice toate celelalte secțiuni.

Directiva «gazdă»

Directiva «Harta site-ului»

Directiva «Harta site-ului» indică locația de căutare agent de fișier sitemap «sitemap.xml». Acest lucru va ajuta la motorul de căutare pentru a găsi rapid fișierul harta site-ului. Dacă site-ul dvs. utilizează mai multe carduri, acestea pot fi indicate după cum urmează:

Verificați dacă fișierul este compilat corect „un robots.txt“, puteți utiliza serviciul special de „Yandex“.

De multe ori există o concepție greșită că «robots.txt» fișier ajută la indexul site-ului. Este greșit. Cu ajutorul fișierului «robots.txt» poate da mai mult timp pentru motorul de căutare pentru indexarea secțiuni utile ale site-ului, dar nu oferă nici o garanție că site-ul dvs. va fi indexat.

Acum, aici voi încerca să descrie utilizarea de roboți «meta tag».

Împiedicați indexarea prin «metaetichetă robots»

Deci, a doua modalitate de a preveni motoarele de căutare de pagini de indexare a unui site - este de a utiliza «Roboți metaetichetă». Exemplu de utilizare:

În acest caz, pagina va fi închisă pentru indexarea de către motoarele de căutare.

Exemple de utilizare «roboți» meta tag

noidex, nofollow

noindex, urmați

index, nofollow

«Roboți Meta tag-ul» are prioritate față de «robots.txt» fișier. cu condiția ca în indexarea fișier este activat și în meta tag-ul este interzisă. Astfel, este posibil, de exemplu, să interzică excepții metoda de indexare.

În general, totul pare să fie că el a vrut să vorbească despre interzicerea indexarea paginilor de către motoarele de căutare. Poate că în viitorul apropiat, voi scrie un articol, cum de a genera în mod programatic «robots.txt» fișier de pe fiecare cerere de ea, precum și să descrie avantajele și dezavantajele acestei metode.

Controlați indexul