roboți fișier txt - descrierea și setarea corectă

Prieteni, datorită instrucțiunilor materialului avem, încă o dată, va organiza un mic, dar foarte important de tuning viața noastră cu tine, ceea ce va ajuta în continuare motoarele de căutare mai repede și mai bine pentru a indexa blog.

Și astăzi, prietenii mei, voi spune despre un document interesant, fără de care blogul dvs. poate fi considerat ca fiind pur și simplu un set de directoare.

Tovarăși, în acest articol vom vă în cele din urmă va descoperi roboți txt.

Și dincolo de asta, vă voi spune despre o metodă interesantă de configurând pentru WordPress, datorită căreia blog-ul dvs. este deja indexat mai bine data viitoare când vizitați un motor de căutare.

Sunt mai mult decât sigur că unii dintre voi știți deja despre ea și să înțeleagă ceea ce au nevoie de acest fișier, și în cazul în care, în cazul în care puteți descărca. Iar pe aceia dintre voi care au auzit despre ea, pentru prima dată, acum, și să se cunoască reciproc.

Pur și simplu pune - este unul dintre documentele de pe proiectul nostru, fără de care nu putem face, și este destinat pentru motoarele de căutare (cum sugerează și numele), care vizitează în mod regulat resursele noastre.

În ce scop a creat acest document?

Datorită lui, prietenii mei, avem capacitatea de a direcționa bot de căutare pentru diverse cataloage ale site-ului nostru, și în același mod, prin intermediul directivelor speciale și instrucțiuni care să-i interzică accesul la oricare dintre locurile de pe site-ul nostru sau pe blog.

Da, asta e ceva de genul asta, și putem să-i spunem - „! Nu intră aici, te duci aici“ Ei bine, în general, înțelegi! Am înțeles?

Mai întâi de toate, un motor de căutare, în contact cu site-ul nostru în rădăcină căutarea de directoare «robots.txt» fișier și imediat citit-o înainte de scanare, și să înțeleagă ce să facă vă permite și ce nu.

Este acest document, și este punctul de plecare pentru robot, înainte de scanarea blog-urile noastre cu tine.

Comoditatea este că, deoarece se poate cu ușurință aproape de indexare (scanare) dosare individuale, documente, și așa mai departe, folosind pentru această echipă specială, care suntem, vom merge un pic mai târziu.

În acest document calea către «sitemap.xml» fișier, care, de asemenea, trebuie să fie prezente în blog-ul dvs., în directorul său principal - rădăcină.

Dacă nu, puteți căuta indicele bot, și, în consecință înregistrate în emiterea, tot felul de resturi, sub formă de pagini duplicat, arhive și așa mai departe, la fel de important și necesar pentru a sări peste pagini.

Cele mai multe recomandări pentru tine, colegii - nu le neglija. Sitemap.xml vital pentru fiecare resursă. Amintiți-vă acest lucru!

Și pentru a crea «robots.txt» este posibilă în notebook-uri de obicei, bine, sau de a folosi pentru aceasta orice alta aplicatie cu virf pentru lucrul cu textul.

Dar, în final, este trebuie să-l aibă în «txt» format. Și după crearea în mod necesar plasa în directorul rădăcină al proiectului cu clientul FTP favorit.

orientări de bază

Și acum, prietenii mei, să vorbim cu tine despre configurația de bază a acestui document important. Deci, să începem cu comenzile cele mai de bază, care indică care dintre roboți motor de căutare care au venit în blogul dvs., următoarele atribute ei prescrise. Se pare ca acest lucru:

Când a ajuns la linia cu ea, și a găsit numele ei, botul va recunoaște că în urma directivele sale sunt menite să-l.

În acest articol noi suntem cu voi, tovarăși, pentru a atinge doar pe două motoare de căutare - Yandex și Google, ca restul dintre noi la nimic. Și, în consecință, vom afla mai multe despre modul de creare a documentului, adaptarea la cerințele lor.

Comanda pentru Yandex bot va arăta în felul următor:

Pentru Google, la fel ca acest lucru:

Dacă după «User-Agent» asteriscul - „*“, notele se aplică imediat tuturor roboți.

De asemenea, în roboți pot, și ar trebui să conțină o comandă:

Aceasta este o comandă obligatorie, iar aceasta înseamnă că, după cele două puncte următoare secțiuni (fiecare secțiune pe o linie nouă) index este interzisă. Și robotul în aceste directoare și de a face nici măcar privirea.

Asta e indicația putem dezactiva indexarea pentru toate întregul blog:

Dar, dacă nu doriți ca proiectul a ramas necunoscut multora, acest lucru nu este în valoare.

Interdicția privind indexarea fișierelor individuale pot arăta astfel:

Această comandă am specificat roboți de căutare, în acest caz, tot ce se târăsc în dosarul «cgi-bin» este imposibil. Prinzi esența? Ei bine, atunci du-te mai departe!

În plus față de comanda de interzicere de indexare, așa cum există și opusul ei - «Permite». Este folosit foarte des, dar să fie conștienți de acest lucru este încă necesar.

În cazul în care unele documente și foldere de pe blog-ul dvs. nu este înregistrat conformitate cu interdicția de indexare, robot de căutare le ia în mod necesar în baza sa de date. Amintiți-vă acest lucru!

Puteți dezactiva indexarea într-un fișier separat, astfel:

Acum suntem închise din indexare «privet.html», situat în directorul principal de blog.

documente Doar strânse și în cataloage:

Cu această echipă, am închis fișierul de a fi indexate «SITE.html», care se află în «wp-content» directorul, care se află în rădăcina blogului.

Doar amintiți-vă că «robots.txt» și trebuie să specifice calea către harta site-ului. dacă o faci, desigur, utilizați. sitemap Directiva - «sitemap».

Apropo, «Permiteți» comandă poate permite indexarea un dosar cu imagini descărcate, dacă vă, desigur, necesar. Se va arăta în felul următor:

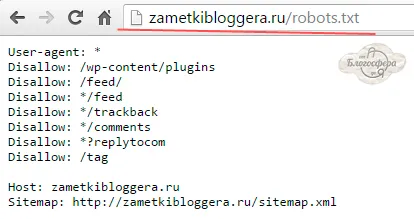

Vezi «robots.txt» pe oricare dintre site-urile preferate, puteți on-line prin tastarea în numele dvs. de blog-ul de browser după slash indică numele său.

Acesta este modul în care: «zametkibloggera.ru/robots.txt». Și browser-ul arată imediat la tine. Puteți încerca și verificați-l pentru oricare dintre resursele acum.

Apropo, uita-te un «robots.txt» folosesc motoarele de căutare ei înșiși. Dar acest lucru este atât, pentru interesul.

Și pe blogul său, am folosi doar o astfel de configurație aici, și consider că este cea mai potrivită pentru toate opțiunile posibile:

Punerea în practică a terminat documentul «robots.txt» este necesară numai în directorul rădăcină al resursei, în caz contrar robotul nu se va găsi și, în consecință, toate aceste comenzi nu sunt îndeplinite, și limitele sunt luate în considerare. Este important de știut!

Doar vezi că directiva «gazdă» prezent în versiunea noastră de fișier. Este prescris numai pentru robotul Yandex, și punctele de la oglinda primară a vieții tale.

Asta este tot ce ai nevoie pentru a face prieteni, deci este copia că Roboți fișier, ți-am dat un pic mai mare, modifica aici aceste două directive:

Ei bine, acum, colegii, și știi cum să facă «robots.txt» fișier. În acest finisaj va istorisi despre asta. Sper că sunt termeni comuni, acum aveți o idee despre asta.

recomanda

prelucrare foto profesionale, ocupație destul de laborios și complex, și să-l învețe pe cont propriu, fără a fi nevoie să viziteze cursuri și instructaje speciale, nu este posibil.

Aceste gânduri se rotesc în capul meu de oameni care sa crezut despre, să stăpânească această meserie.

Dar, prieteni, vă spun, că nu este așa! Aflați cum să fie retușată profesional fotografii pot fi și de cele mai multe, dar cum se face? Este foarte simplu!

Vă oferim un curs unic, care va ajuta pe toți să dobândească abilitățile necesare în această direcție.

Cursul se numește „retușare Workshop“ și conține numai piese practice de hârtie cu imagini, nici o teorie uscată și plictisitoare.

În general, mult timp pentru a picta beneficiile acestui curs, nu voi, mai bine ajunge să se cunoască pe sine. Iată detaliile.

Și, desigur, nu trec prin distribuirea proiectului, va fi foarte bucuros dacă mă lăsați detaliile de contact pentru a comunica.

Ei bine, vă spun la revedere de la tine, prietenii mei! Ai grija de tine!

Cu stimă Dmitry Khudyakov!