accelera metodele de învățare ale rețelei neuronale

Algoritmul de propagare înapoi este o metodă de formare a rețelelor neuronale multistrat de distribuție directă. Astăzi, rețelele neuronale au fost folosite cu succes în rezolvarea problemelor practice complexe.

Într-un clasic exemplu de realizare formula backpropagation algoritm greutăți de corecție după cum urmează:

- - numărul de repetare curentă a învățării;

- - valoarea greutății sinaptice conectarea neuron la neuron;

- - coeficient de „rata de învățare“, controlează cantitatea de schimbare a greutăților;

- - neuroni de eroare;

- - ieșirea neuronului.

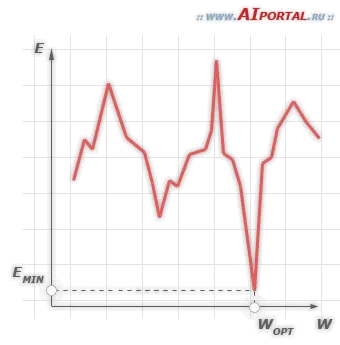

Aici - o constantă. Pentru valori foarte mici ale formării rețelei neuronale va fi lent. La valori foarte mari, se ridică probabilitatea ca, la atingerea rețelei minime neuronale funcția de eroare nu va fi capabil de a obține în acest puțin, și va pe termen nelimitat pentru a „sari“ la dreapta și la stânga lui, recalcularea coeficienților de ponderare.

Alegerea o anumită valoare medie pentru toate procesul de învățare nu permite atingerea setului optim de coeficienți de greutate pentru numărul minim de etape. Devine evident că amploarea managementului dinamic poate îmbunătăți în mod substanțial eficiența de formare a rețelei neuronale prin propagare înapoi.

Atribuirea unei valori mai mari la începutul formării va oferi o abordare mai rapidă a câmpului, în cazul în care setul optim de coeficienți de ponderare. Și la rețeaua de neuronale nu „skip“ este necesară în procesul de învățare minim de erori pentru a reduce valoarea. Este posibil, de exemplu, prin următoarea ecuație simplă:

Este demn de remarcat faptul că există mecanisme mai complexe pentru accelerarea formării de rețele neuronale, vă permit să schimbați viteza de învățare a fiecărui neuron în parte, în funcție de valoarea erorii sale la iterația precedentă.

Controlul dinamic al vitezei de antrenare a rețelei neuronale, în cele mai multe cazuri, se poate îmbunătăți în mod semnificativ eficiența algoritmului de back-propagare.