Sfaturi pentru utilizarea corectă a fișierului - devaka blog-SEO

Într-unul din mesajele sale Twitter, am menționat că robots.txt este rău și ceea ce este, mai mult rău îl aduce la site-ul. Confruntându-se cu o mulțime de confuzie, inclusiv în momentul în care opiniile sunt împărțite optimizatori clare cu privire la această problemă, atunci când unii webmasteri utilizează recomandările vechi, vreau să fac un fel de claritate în utilizarea acestui fișier în mediul actual.

Este clar că diferitele directive sunt utilizate în robots.txt. Printre acestea, există multe utile:

Există, de asemenea, o directivă Interdicție (și să permită contrariul). Este vorba de ele și vor fi discutate în acest articol.

Care sunt problemele cu care se confruntă webmasteri folosind robots.txt?

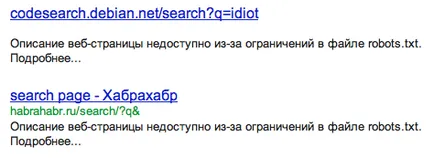

Prima și principala problemă cu care se confruntă webmasteri, este prezența în paginile indexul Google, care au fost închise în robots.txt. Se crede că, dacă închideți o pagină sau o secțiune în robots.txt, acesta nu va cădea în index, sau picătură din ea, dacă nu a existat. Acesta este doar ceea ce funcționează bine pentru Yandex, Google robots.txt percepe în mod diferit.

Pentru a închide paginile duplicat să utilizeze mai eficient CMS căi de atac interne. și nu încercați să vă facă viața mai ușoară de robots.txt. Mai mult decât atât, acest fișier poate, indiferent de motiv, să nu fie disponibile (mutat la un alt server, uitat, redenumit, și așa mai departe) și, în acest caz, toate închise brusc devine deschis (probabil la fel ca în cazul scurgerii anterioare din wiki.yandex-team .ru).

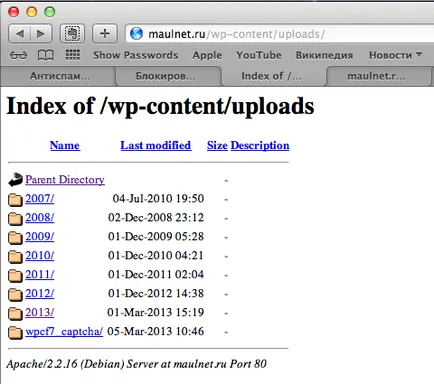

În al doilea rând, închiderea totul, puteți închide accidental lucrurile importante. De exemplu, închiderea unui dosar întreg WordPress / wp-content /. Puteți rămâne fără trafic în imagini, care sunt stocate în wp-content / / uploads /.

Aici sunt stocate imaginea, dar în imaginile care nu caută:

Deci, se pare că este mai bine să nu utilizeze robots.txt? În unele cazuri, este încă util (mai ales atunci când prescriem oglinda principală pentru Yandex).

Ceea ce am recomanda utilizarea robots.txt

- Pentru a închide întregul site-ul în timpul dezvoltării sale

Pentru a avansa în index nu are nimic mai mult. - Pentru a închide site-ul din motoarele de căutare din stânga.

De exemplu, site-urile Runet nu are nici un sens pentru a arăta la Yahoo! Dacă motorul de căutare nu este publicul țintă, puteți închide site-ul, astfel încât să nu mai departe povara serverele lor. - Pentru a închide secțiunile private ale site-ului de la ochi a robotului.

Pentru date private (cum ar fi numere de card de credit sau parole 🙂 SMS utilizatori) nu se încadrează în index. În timp ce în mod logic, aceste secțiuni nu trebuie să deschidă site-ul. - Pentru a elimina sarcina pe server

În cazul în care, de exemplu, pe site-ul dvs. foarte popular pentru multe bunuri sotrirovke funcționale, sau orice filtre care necesită mai multe resurse de server, nu puteți lăsa robotul în aceste pagini pentru a lua greutatea. Deși, din nou, de conectare ar face sortarea funcționalitatea invizibil pentru robot CMS. decât transferul de responsabilitate în fișierul robots.txt.

Ceea ce nu aș recomanda utilizarea robots.txt

- Pentru a închide paginare pagini de index, sortarea, căutarea

Din duplicate trebuie eliminate instrumente CMS. de exemplu, 301 de redirecționare. tag rel = canonic (care este în mod special în acest scop, a fost stabilit), 404 sau meta roboți NOINDEX. - Pentru a șterge paginile existente în index

O comune webmasteri greșeală când încearcă să elimine pagina de Roboți index. Crawlerul nu va fi în măsură să re-indexeze pagina și ștergeți-l dacă aveți acces aproape de ea prin roboți. - Pentru a închide panoul de administrare

de calea de admin este vizibilă în roboți. Deci, la conferința Optimization.by, colegii mei și cu rea intenție a avea acces la un admin site despre cursuri, calea pe care a învățat printr-un robots.txt și parolele au fost admin standard: admin. - Pentru a închide celelalte pagini pe care nu doriți să vedeți indexul

Utilizarea altor metode

SEO-analist, consultant. Întotdeauna la curent cu noile tendințe pe piața SEO.

„În cazul în care motorul de căutare nu este publicul țintă, puteți închide site-ul, astfel încât să nu mai departe povara serverele lor.“

În cazul în care sarcina să se teamă de numărul de vizite la unele motor de căutare - acest lucru este cât de mult ar trebui să meargă la oamenii din acest motor de căutare pe site-ul pe unele cerere? În acest caz, persoanele interesate de cuvinte cheie, dar site-ul nu este interesat de aceste persoane?

Yan. dacă bine oamenilor. Ideea este că motorul de căutare primul indexează site-ului. Iar pentru ceva timp Yahoo! a indexat foarte agresiv, uneori, a mers la server. De aceea, am venit cu o directivă crawl întârziere. Aici descrierea aspect mai degrabă tehnic, nu un utilizator.

Am înțeles corect pe rel = „canonic“?

1. În cazul în care un blog are 100 de pagini, tipul de posturi primare, dar mai mari, pe fiecare pagină (pagina 1, 2, 3) trebuie să fie link URL a paginii principale, și în principal, de asemenea?

Sau doar da o adresă URL, în principal în sine, și tot ca tine?

2. Pur și simplu nu pot înțelege cum acest REL Canonical.

De exemplu: Am un 20 de pagini, toate indică o rel legătură și URL-ul Canonical de 1 pagină. Pentru Google, acest lucru înseamnă că indicele nevoie doar de 1 pagină? Corect?

dar, probabil, într-un robots.txt nu este necesar să se prescrie gazdă care nu știe gazda este site-ul oglinzii principale, sunt aici o dată nu este înregistrată și am site-ul indexat cu o altă oglindă

Și ai putea spune cu ajutorul unei echipe ar putea bloca accesul la anumite site-ul de posturi de a fi indexat de intrare și de vizitatori (ar fi disponibile doar pentru administrator)

Tu spui că utilizarea de rău robots.txt pentru că puteți face rău în urma propria lor prostie - e de înțeles. Al doilea minus robots.txt cheie - Google încă indici. Sunt corecta pentru a capta esența downsides roboți?

Pornind de la aceste dezavantaje, am înceta să mai înțeleagă concluziile suplimentare în articol.

1. vă recomandăm utilizarea robots.txt pentru a închide prin indexarea cu pagina de informații private (de exemplu, paginile cu numere de carduri de plastic). Deci, pentru că indicele va accesa Google toate la fel?

Am citit și a decis că cel mai bine nu va atinge macar. Cum de a face așa să fie. Și cum nu ar deveni mai rău.

Dacă există orice link-uri rupte, care este mai bine să faci? Scrie-le în robots.txt ca Disallow: sau așteptați pentru indexarea? Google și Yandex scade rating de link-uri întrerupte?

Ceea ce nu-l închide, atribute, și alte gadget-uri. Am juca pe teren și canids după regulile lor. Yasha - proprietarul resursei, și este mai bine să nu arate prea mult, iar în acest caz, va (alias de căutare motor), și de a pedepsi. Sunt pe un hosting - rata gratuit și toate link-urile sunt închise atribut notoriu. Recent, pentru un motiv sau altul, au început să apară în Bekah JMM. Prin întregul cod al ambelor site-uri - Hoster nu a fost curățată nofollou. Pe scurt câine pofigu Hoster, nofolou, noindeks și altele. Pofigu yuzverg, el aduce banii pentru noi toți și să-l!

Trebuie să joci cinstit, pentru ca să nu fie în măsură să bată a priori!

Robots.txt uitat la site-ul tau. Este ușor diferită de cea dată în articol. Am înțeles că locul nu valorează nimic. Modificările apar atunci când semnificative, și când nu.

Am fost cel mai interesat în tag-ul aproape sau nu pentru a închide?

Hmm ... Spune-mi, yukoz toată lumea spune că el robots.txt reglat perfect, indiferent dacă este adevărat sau este tot aceeași nevoie de a edita.

Ai recomanda utilizarea robots.txt pentru a închide prin indexare cu pagina de informații private (de exemplu, paginile cu numere de carduri de plastic). Deci, pentru că indicele va accesa Google toate la fel?

Există pagini care nu pot ajunge pe nimeni din exterior (fără legături), cu excepția informațiilor private a proprietarului. În cazul în care aceste pagini nu sunt închise, poate indexat de motoarele de căutare (așa cum a fost cazul cu un fel de MegaFon dacă vă amintiți aceste dezasamblarea).

La urma urmei, de referință rel = „canonic“ poate fi doar o pagină este conținut aproape identic. Atunci când paginarea a doua pagină va fi ceva cu totul diferit de cel în prima.

Da, ai dreptate, pagina va fi diferit, dar încă Canonical pot fi utilizate și în astfel de cazuri, acesta va funcționa. Un alt lucru este faptul că acum câteva zile Google nu este recomandat să utilizați această etichetă pentru paginare, da. tag-uri oferă în schimb rel = anterioare și rel = next.

Dacă există orice link-uri rupte, care este mai bine să faci? Scrie-le în robots.txt ca Disallow: sau așteptați pentru indexarea? Google și Yandex scade rating de link-uri întrerupte?

Broken link-uri de pe site-ul dvs. sau de a ta? În general, cel mai bine este să contactați webmasterul și să facă legături rupte nu sunt deteriorate. Dacă acest lucru nu este posibil, atunci înființat în propriul CMS (sau server), care, la link-ul de lilieci predat informații utile (pagina de cel puțin 404, cu o ofertă bogată de alte opțiuni de pagini).

Am fost cel mai interesat în tag-ul aproape sau nu pentru a închide?

Dacă aceste pagini nu aduce valoare adăugată pe site (cu excepția de navigare), nu este chiar aproape, și se îndepărtează de pe site. Dar IMHO.

Yukoz spune tuturor că robots.txt a reglat perfect, indiferent dacă este adevărat sau este tot aceeași nevoie de a edita.

Aici nu prompte uCoz nu a funcționat. În orice caz, ar trebui să verificați dacă tot ați configurat corect.

Dragă Serghei, vă mulțumesc foarte mult pentru articol. Ești bine, desigur ... Întrebarea mea este: Am un site Word de presă direct pe hosting și anume Eu nu folosesc un server local pentru Denver „repetiții“. Așa că am creat un site testiruem.imya subdomeniu. Cum pot face „invizibil“ pentru motoarele de căutare? Puteți utiliza robots.txt? Vă mulțumesc foarte mult în avans

Ca motoarele de căutare a primit =) să fiu sincer - întotdeauna ceva la lopata perefiltrovovayut, nu s-ar fi așezat și au convenit să lucreze împreună la un standard comun - astfel încât toate au un singur set și au fost un standard unic!

Aici sa întâlnit afirmația că directivele robots.txt sunt obligatorii din punct de vedere ca o axiomă. Dar acest lucru nu este adevărat! Închis pentru site-ul în robots.txt prima pentru directoarele care nu au nevoie de indexare, apoi pagini individuale, care deja net.Bespolezno! După un alt pagini încă APA inexistente agățate în căutare.

Numai după contactarea feedback-ul Platos schutskiny a spus că ei vor face nimic. În primul rând, toate răspunsul standard apoi în scris, într-o formă pe Yandex. Și numai după ce aceste pagini inexistente a dispărut.

Deci, Yandex, cel puțin nu se supune întotdeauna directivele ...

„Pentru a închide paginare pagini de index, sortarea, căutarea

Din duplicate trebuie eliminate instrumente CMS. de exemplu, redirecționare 301, tag rel = canonic (care este în mod special în acest scop, a fost stabilit), 404 sau roboți meta tag noindex ".

Pot să vă rugăm să spuneți cum să rezolve problema cu faptul că pagina principală blog poate duce link-uri diferite. De exemplu, o jumătate www. și jumătate fără www. Acest lucru ar putea afecta negativ clasarea site-ului?

Serghei, după-amiază bună.

Astăzi, a atras atenția asupra unui rival, mai mult de un an pe locul 1 în Yandex.

cel mai lung astfel lui robot.txt pentru Yandex și Google, probabil 50-100 linii.

Ce crezi că joacă un important în discuție?

Serghei, și puteți scrie doar câteva pagini aici? Aș dori să aduc site-ul aproape de starea ideală. La începutul lunii mai, pentru a fixa versiunea mobilă, și va fi decent. Un detaliu cu privire la orice mare.

mebelona.ru/mebel/krovati/ și mebelona.ru/tip_mebeli/krovati/

Nu pot convinge cumva dezvoltator pentru a face o redirecționare pe oglinda principală cu www. 🙂

Vă mulțumesc foarte mult, Serghei! Copiați răspunsul la dezvoltator. El htaccess, astfel încât ea nu a îndrăznit să urce. ori Slazit deja. ))

Bine ai venit! Spune-mi, te rog, un moment.

Cand va fi complet închis deja în căutarea și indicele de pe un site din fragmentele de extrădare apar expresii à la „Site-ul este închis de indexare.“ Pot cumva evita acest lucru? Fă-l, astfel încât chiar și după închiderea fragmentelor de indexare a rămas aceeași.

Bună ziua.

Eu am aceeași problemă ca și în Makar, numai eu nu am căutat pe site în orice motor de căutare :(.

Inițial, de asemenea, nu am fost configurat robots.txt, dar apoi a făcut și a adăugat o hartă a site.

După adăugarea a încercat, prin panoul de webmaster în Google și Yandex.

Dar nici unul din DONE nu a produs rezultatele :(. Site-ul în interogări Google și Yandex nu este :(.

Spune-mi ce altceva ar putea fi motivul și unde să sape?