Note admin virtuală februarie 2018

În acest post ne vom uita la două vSphere de management diferite adâncimi tehnologii coadă pe gazde ESXi. Rândul său, determină valoarea operațiunilor IO programate, care pot fi trimise la stocare. În cazul vSphere, în cazul în care în mod obișnuit un dispozitiv de disc partajat accesează mai multe gazde pot fi utile pentru a controla adâncimea în punctele coadă la lipsa de resurse. În acest articol vom compara Adaptive cozilor de așteptare și de stocare Controlul I / O (SiOC).

Ceea ce aceste tehnologii sunt diferite?

SiOC utilizează conceptul de nivelul congestiei bazat pe întârzierile în accesul. De fapt, în cazul în care întârzierea pe un anumit datastore depășește un anumit prag - rândul său, SiOC. Acest prag poate fi setată manual (implicit 30ms) sau automat prin cererile de injectare (depuse 5.1). În cazul adaptiv de control coadă vSphere de așteptare pentru apariția efectivă a lipsei de resurse, care este primit de la sistemul de stocare ca răspuns la cererea USY SCSI IO Echipa sau COADĂ FULL.

Managementul adaptiv coadă nu este atât de flexibil - în cazul umplerii cozii de instrucțiuni, adâncimea cozii a gazdei la LUN tăiate în jumătate. Prin urmare, este foarte important ca toate gazdele conectate la o singură gazdă a fost inclus de management adaptiv coadă. Activarea acestei funcții numai pe partea gazdelor duce la degradarea gravă de performanță, deoarece toate vor fi sacrificate numai în unele gazde, dar nu toate. Odată ce coada este procesată - este din nou incremental începe să se umple.

Atunci când a fost prezentată o tehnologie?

SiOC a fost introdus pentru prima dată în vSphere 4.1 pentru dispozitivele bloc și vSphere 5.0 pentru NAS. Controlul adaptiv al coadă - în ESX 3.5U4.

Pentru a activa managementul adaptiv coadă trebuie să se extindă fiecare gazdă setări individuale, du-te la secțiunea Disk, și modificați setările și Disk.QFullSampleSize Disk.QFullThreshold. opțiunea implicită QFullSampleSize este setată la 0, care este oprit și QFullThreshold editează numărul necesar de echipe privind normalizarea statutului pentru a debloca.

rezultate

Fiecare funcție poate aduce avantajul în infrastructura. SiOC, comparativ cu o adâncime de coadă de adaptare, tehnologie mai flexibilă, dar este disponibil doar în Enterprise +. Dar, la rândul său, necesită o coadă setările adaptive pe fiecare gazdă. De asemenea, în cazul în care porturile de depozitare sunt folosite pentru a lucra cu alte sisteme de operare, nu numai vSphere, vă recomandăm să citiți următorul articol din baza de cunoștințe: 1008113.

Oamenii partajat mental de stocare pe proprietățile lor fizice, cum ar fi de interconectare (toate folosesc Infiniband!), Protocol (stocare bloc! Sau NFS! Sau multiprokolnaya!) Sau chiar și hardware-ul este fie o soluție software (este doar un software de pe server!).

Nu este taxonomie corectă și un mod greșit în grup! arhitectura software - acesta este principiul de bază al grupării, așa cum este pentru el sunt determinate de factorii fundamentali. Toate celelalte elemente - în special punerea în aplicare a arhitecturii.

Nu mă înțelegeți greșit - acestea sunt importante, dar nu fundamental.

Tip 1 arhitectură clustering (vertical scalabil)

Aceste soluții sunt caracterizate prin faptul că memoria partajată între controlorii nu le folosesc, și, de fapt, datele sunt în cache-ul per controler. Depozitarea poate fi A / A (ambele controlori sunt active), A / P (un controler este pasiv), A / S (fiecare controler procesează cantitatea sa de date, adică într-o controlerele asimetrice de acces la date).

Prelucrarea acestor date de stocare este după cum urmează:

- Întârzierea dintre controlori este minim. Aproape de zero.

- Viteza de matrice depinde de disc.

- Deoarece întârzieri în astfel de decizii este minimă, atunci sistemul de stocare ideală pentru modelul de acces la date tranzacțional.

- Arhitectura simplă și comunicare minimă între controlerele face arhitectura este foarte ușor de a extinde funcționalitatea (compresie, deduplicare, lăcrimare).

- Ușor de întreținut, gestiona, configurați.

- Scalabilitatea este limitat sau puterea pereche controler. De obicei, până la 1000 de discuri.

- Disponibilitatea datelor este garantată între controlori de comutare. Acest lucru poate duce la diminuarea performanțelor, atunci când producția unui sistem.

- Controlerul în sine și componentele sale - hardware și software.

- Dispozitive de acționare, porturile din fabrică, etc.

- Activ / Suplu standby, Depozitare Pure, Tintri, UCS Whiptail

- Activ / pasiv NetApp, EMC VNX *

- Active / HDS SHU, activ, cu Dell, EMC Compellent VNX *, IBM V7000

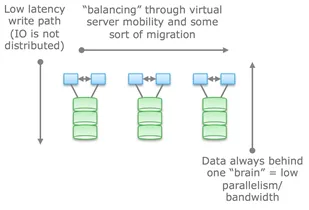

Pe partea de sus a acestei puteți pune o decizie federale pentru a le face mai orizontal scalabilă din punct de vedere al managementului. Cu toate acestea IO va fi echilibrat exact la datele introduse în controler. Asemenea soluții pot fi de asemenea utilizate pentru echilibrarea între controlori și bazine (VDM Mobility VNX y și y ONTAP fascicular NetApp). Cât despre mine, o astfel de decizie poate fi o intindere de a apela orizontal scalabile. Având în vedere că datele într-un fel sau altul, se află în spatele unul sau celălalt controler. Echilibrarea si tuning sunt importante, spre deosebire de arhitecturi 2 și 3, în cazul în care pur și simplu este.

Tipul 2. cuplat Vag (orizontal scalabil)

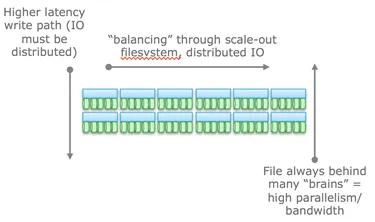

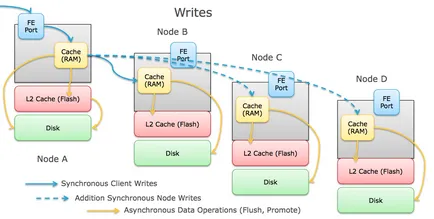

sunete arhitecturale, cum ar fi cea mai ușoară soluție, dar de fapt, aceasta este cea mai grea decizie. Această soluție, de asemenea, nu utilizează memoria partajată între noduri, dar datele sunt distribuite pe nodurile stabilite. De asemenea, o astfel de soluție caracterizată de un număr mare de comunicații între noduri în înregistrările de date (operație costisitoare în ceea ce privește întârzierile). Dar ei sunt încă tranzacționale - înregistrarea, deși divizată, dar consistente.

Observați în imaginea indicată de către nodul fără failover, se crede că stabilitatea este garantată și distribuite copii ale datelor.

De obicei, întârzierea în astfel de matrice de stocare secretă latență scăzută (NVRAM, SSD, etc.), dar, în orice caz, probleme întotdeauna mai mare de echilibrare și de backup de date decât un tip de cluster convențional 1 ca operația de înregistrare distribuită.

Uneori, un grup de noduri, stoca doar metadate despre nodah restul. Logica este similar cu federația în arhitectura anterioară.

Avantajul unei astfel de arhitectură pentru a controla și ușurința de scalabilitate. Orizontal sisteme scalabile sunt ideale pentru sarcini tranzacționale din cauza naturii distribuite acestor nu este tolerant la erori de server, puteți utiliza sistemele nu sunt interconectate, cu care face față perfect simplu Ethernet vechi.

În ciuda faptului că metodele de interconectare pot varia (Ethernet, Infiniband, etc), toate aceste soluții nu este un loc important pentru o rețea de înregistrări de date distribuite. Confirmarea de intrare va fi trimisă către inițiatorul numai după înregistrarea datelor de succes pe mai multe nodah diferite. Aceasta, la rândul său, duce la creșterea zonei eșec. Acești doi parametri sunt factorii majori care limitează domeniul de aplicare.

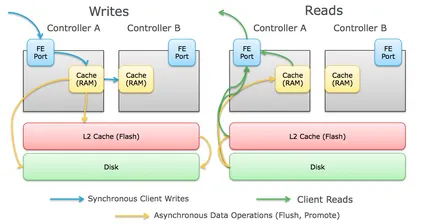

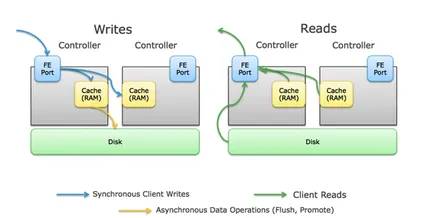

prelucrarea de scriere a cererii este după cum urmează:

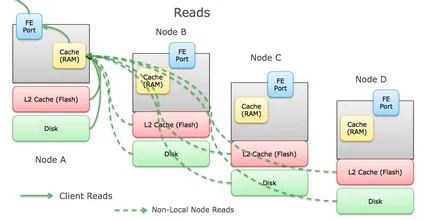

Și, în consecință, pentru a citi:

Memoria partajată este un moment critic pentru această arhitectură. Inițial, aceasta a permis

În ciuda faptului că o schemă a acestei arhitecturi este foarte similar cu cel anterior, diferența este că modelul de metadate distribuite și partajate înseamnă că astfel de soluții nu pur și simplu utilizați Infiniband, și RDMA depind pentru schimbul și partajarea metadatelor între noduri.

Luați, de exemplu, cele două soluții de la EMC - Isilon și XtremeIO. În ciuda faptului că acestea sunt ambele foarte similare - ambele soluții sunt orizontal scalabile si ambele folosesc interconectare Infiniband pentru diferența este că Isilon utilizează Infiniband pentru a minimiza întârzierea între noduri, și nu utilizează memoria partajată între noduri. De fapt, Isilon poate folosi Ethernet (și în versiunea VA) și XtremeIO dependentă de RDMA.

O altă diferență importantă punct între cele două arhitecturi: cele mai multe regulatoare sunt conectate între ele, scalabilitatea mai mici și mai puțin previzibile, va întârzia dar mai puțin datorită creșterii complexității.

operațiune IO sunt după cum urmează:

- Întârzieri între controlori practic zero

- întârziere de intrare de date depinde în principal de discuri fizice

- Ideal pentru sisteme grele

- performanțe limitate scalabilitate garantate

- Scalabilitate limitat la un număr maxim de controlere

- Deși unele sisteme utilizează arhitectura x86, care este folosit pentru hardware-ul lor. În alte cazuri, utilizarea ASIC. Ambii acești factori duc la o tranziție lungă la noua tehnologie.

- Arhitectura este conceput ținând cont de absența oricărui element sau toleranță la defecte.

- EMC Symmetrix VMAX

- HDS VSP

- HP 3PAR

În sistemele distribuite nu utilizează memoria partajată, datele sunt separate în diferite noduri la, dar nu transactionally și „leneș“. Aceasta este, datele sunt înregistrate pe un nod, și cu o anumită periodicitate (uneori) sunt copiate la alte noduri pentru a asigura securitatea. Sistemele de acest tip nu sunt tranzacționale.

interkonnet Inevitabilă întotdeauna construit pe Ethernet (doar pentru că este ieftin și întotdeauna disponibile), nodul nu este vina tolerant. Corectitudinea de stocare a datelor nu este întotdeauna asigurată, iar stiva software-ul de mai sus, prin intermediul sumei de control.

Aceasta simplitate face ca arhitectura cea mai scalabilă dintre toate. Ea nu are absolut nici o dependență de hardware-ul, și sunt aproape întotdeauna executate în formă de software. PB scalate cu aceeași ușurință ca și alt sistem de stocare la terabytes. Acesta este utilizat în mod obișnuit obiectul și sisteme de fișiere non-POSIX sunt de multe ori chiar și situată în partea de sus a sistemului de fișiere local, utilizat pentru sarcini de bază.

exemple:- HDFS

- EMC Atmos

- Blocați accesul la EMC ViPR

- Amazon AWS S3 (deși nimeni în afara Amazon nu știe cum să într-adevăr este cazul, am tendința de tip 3)

- Ceph

- OpenStack Swift

Original: vmtyler.com