Hopfield de rețea - studopediya

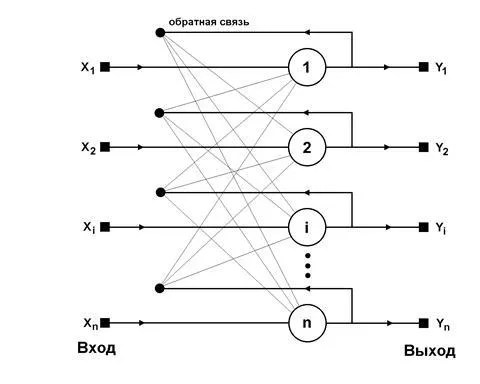

Fig. 6.1 Structura generalizată a rețelei Hopfield

Acest lucru înseamnă că semnalul de ieșire neuron este determinată de funcția:

unde reprezintă numărul de neuroni.

Presupunem că elementele de prag sunt componente ale unui vector. Excluzând întârzieri ale rețelei unice, care sunt o modalitate de sincronizare a procesului de transmitere a semnalului, funcția principală care definește rețeaua Hopfield poate fi reprezentat ca:

cu condiția inițială. În timpul funcționării, două moduri pot fi identificate în rețea Hopfield: formare și clasificare. În modul de învățare bazată pe probele de formare cunoscute ponderi selectate. Modul de clasificare cu valori fixe de greutăți de intrare și o anumită stare de tranzitie initiala are loc procesul de neuronale care apare în conformitate cu expresia (6.5) și se termină într-una dintre minimele locale pentru asta.

Atunci când intră doar un singur proces de formare continuă schimbare probă, atâta timp cât relația (6.5) începe să fie observat pentru toți neuronii. Această condiție este realizată automat în cazul selectării valorilor la scară corespunzătoare relativă

deoarece numai (raport întotdeauna satisfăcut datorită valorilor bipolare ale elementelor vectoriale). Trebuie remarcat faptul că relația (6.6) este o regulă de învățare Hebb. La introducerea unui număr mare de probe de formare sunt adaptate în funcție de greutatea generalizată regula Hebb, potrivit căreia

Din cauza unui astfel de regim de formare în greutate sunt așa cum este determinat prin calcularea mediei set de probe de formare.

În cazul unei multitudini de probe de formare devine factor relevant de stabilitate de memorie asociativă. Pentru o funcționare stabilă a rețelei este necesar ca reacția din proba de formare th neuron -lea a coincis cu componenta sa -lea. Acest lucru înseamnă că, în ceea ce privește expresia (6.7), obținem

Dacă suma ponderată a semnalelor de intrare desemna lea neuron, este posibil să se facă distincția în ea valoarea așteptată și reziduul, denumit Video monitorizat [4]:

Datorită utilizării funcției semn este activată, condiția (6.8) este posibilă la valori scăzute, nu Diaphony putea schimba semnul. Aceasta înseamnă că, în ciuda unor biți de nepotrivire, procesul de tranziție este finalizat la punctul dorit de greutate. Prevăzând proba de testare, caracterizat printr-un număr de biți, o rețea neuronală poate ajusta acești biți și să finalizeze procesul de etichetare la punctul dorit de greutate.

Cu toate acestea, regula Hebb are o productivitate scăzută. Capacitatea maximă de memorie asociativă (numărul probelor stocate) în timpul formării prin regula Hebbiane cu o eroare admisibilă de 1%, aproximativ 14% din neuronii rețelei [4]. Mai mult, prezența zgomotului, folosiți regula Hebb conduce la diferite inexactități în formă de minimele locale îndepărtate de soluția inițială. Prin urmare, ca o alternativă la utilizarea metodelor de predare bazate pe pseudoinversion.

unde - rețea de matrice greutăți dimensiune, și - o matrice dreptunghiulară de dimensiune compus din vectori de formare consecutive, adică. Soluția acestui sistem liniar de ecuații are forma:

unde simbolul + denota pseudoinverse. În cazul în care vectorii de formare sunt liniar independente, ultima expresie poate fi reprezentat sub forma:

Dimensiunea matricei pseudoinverse în această expresie este înlocuită cu o dimensiune inversă convențională pătrată a matricei. Un avantaj suplimentar al expresiei (6.12) - Capacitatea de a se scrie într-o formă iterativ care nu necesită calculul matricei inverse. În acest caz, expresia (6.12) ia forma unei funcții a secvenței de formare a vectorilor:

condițiile inițiale. Această formă presupune o singură prezentare a tuturor probelor de formare, rezultând într-o matrice de greutate are o valoare. Dependența (6.12) și (6.13) sunt numite de proiecțiile. Aplicarea metodei pseudoinversion crește capacitatea maximă a rețelei Hopfield care devine.

O versiune modificată a metodei de proiecție - metoda proiecției - o formă a algoritmului de gradient pentru a minimiza funcția obiectiv. În conformitate cu această metodă, greutățile sunt selectate recursiv folosind o procedură ciclică se repetă pentru toate probele de formare:

Factor - este de învățare raportul ales, de obicei, în intervalul [0.7-0.9]. Procesul de învățare este finalizat atunci când schimbarea vectorului de greutăți devine mai puțin a priori valoare presupusă.

Conform realizării de selecție greutățile rețelei de valorile lor sunt „înghețate“, și puteți utiliza rețeaua în modul de învățare. În această fază, vectorul test de rețea este de intrare și răspunsul său se calculează astfel:

(Timpul inițial), procesul iterativ se repetă pentru valori succesive până la stabilizarea răspunsului.

În procesul de recunoaștere a semnalelor de imagine zgomotoase care formează starea inițială de neuroni, apar probleme cu determinarea stării finale corespunzătoare uneia dintre imaginile stocate. decizii eronate posibile. Un motiv pentru găsirea soluțiilor eronate este capacitatea de amestecare diferitelor componente stocate imagini și formând o stare stabila perceput ca un minim local.